Facebook está desarrollando robots domésticos que hagan tareas mediante IA

Facebook está desarrollando robots domésticos que mediante Inteligencia Artificial, realicen infinidad de tareas

Facebook está desarrollando robots domésticos que mediante Inteligencia Artificial, realicen infinidad de tareas

Investigadores de Facebook crearon una herramienta de código abierto llamada SoundSpaces, diseñada para la llamada «IA Incorporada», un campo de inteligencia artificial que se interesa en adaptar los cuerpos físicos como robots, con software, antes de entrenar los sistemas en entornos de la vida real.

En lugar de utilizar conjuntos de datos estáticos, como la mayoría de los métodos tradicionales de IA, la Inteligencia Artificial incorporada favorece un enfoque que aprovecha el aprendizaje por refuerzo, en el que los robots aprenden de sus interacciones con el mundo físico real.

En este caso, SoundSpaces permite a los desarrolladores entrenar sistemas de IA incorporados virtuales en entornos 3D que representan espacios interiores, con una acústica altamente realista que puede simular cualquier fuente de sonido, en una casa de dos pisos o en el piso de una oficina.

La incorporación de la detección de audio en el entrenamiento permite a los sistemas de inteligencia artificial identificar correctamente diferentes sonidos, pero también adivinar de dónde proviene el sonido y luego usar lo que escucharon como un objetivo emisor de sonido.

El algoritmo se alimenta de datos tomados del modelo de acústica de salas, por ejemplo, puede modelar las propiedades acústicas de superficies específicas, comprender la forma en que los sonidos se mueven a través de geometrías de habitaciones particulares o anticipar cómo se propaga el audio a través de las paredes. Por lo tanto, al escuchar un sonido, el sistema de inteligencia artificial puede determinar si el objetivo emisor está lejos o cerca, hacia la izquierda o hacia la derecha, y luego moverse hacia la fuente.

El equipo de investigación de Facebook encargó a un sistema de inteligencia artificial que encontrara su camino a través de un entorno determinado para encontrar un objeto emisor de sonido, como un teléfono que suena, sin apuntar el algoritmo a ninguna ubicación objetivo específica.

En otras palabras, el asistente virtual es capaz de «oir» y «ver», y de tender un puente entre distintos datos sensoriales para alcanzar un objetivo definido por sus propias percepciones.

De forma alterna, los investigadores lanzaron una nueva herramienta llamada SemanticMapNet, para enseñar a los asistentes virtuales cómo explorar, observar y recordar un espacio desconocido, y de esta forma crear un mapa 3D de su entorno que los sistemas podrían utilizar para futuras tareas.

«Tuvimos que enseñar a la IA a crear un mapa de arriba hacia abajo de un espacio utilizando un punto de vista en primera persona, mientras también construíamos recuerdos episódicos y representaciones espacio-semánticas de espacios 3D para que realmente pudiera recordar dónde están las cosas. A diferencia de cualquier enfoque anterior, tuvimos que crear formas novedosas de memoria», dijo Kristen Grauman, científico investigador de Facebook AI Research.

SemanticMapNet permitirá a los robots informar si cerraron la puerta de entrada con llave o cuántas sillas quedaron en la sala de reuniones del sexto piso.

La tecnología permite que los sistemas de IA incorporados reconozcan objetos particulares, como un sofá o algún mueble de la cocina, desde su vista en primera persona, antes de mapearlos en una representación 3D del espacio que es objetiva y alocéntrica, lo que significa que el mapa es independiente de la ubicación actual del robot en él.

Los métodos tradicionales, por otro lado, se basan en la percepción en primera persona del sistema durante todo el proceso, lo que genera errores e ineficiencias. Los objetos pequeños, por ejemplo, se pasan por alto fácilmente, mientras que el tamaño de los más grandes se subestima con frecuencia.

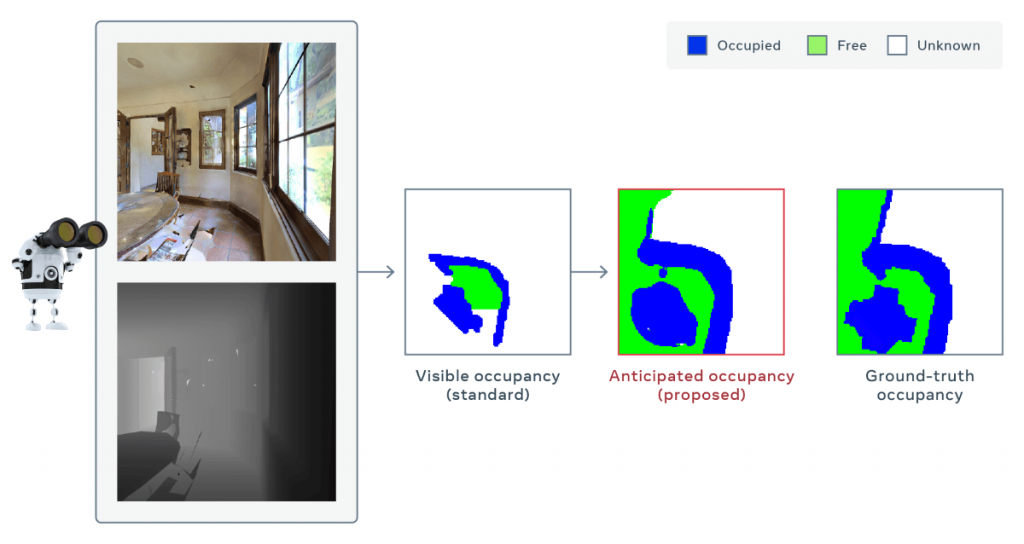

Además, el equipo de investigación también brindó a sus asistentes virtuales la capacidad de anticipar el diseño de las partes de una habitación que no pueden ver.

Con un protocolo llamado «enfoque de anticipación de la ocupación», el sistema de inteligencia artificial puede predecir de forma efectiva partes del mapa que no están observando directamente. Por ejemplo, al mirar en un comedor, el robot puede anticipar que hay espacio libre detrás de la mesa o que la pared parcialmente visible se extiende a un pasillo que está fuera de la vista.

Con esta tecnología, los científicos descubrieron que los robots superaban al «mejor método de la competencia» con una precisión de mapa superior al 30% para la misma cantidad de movimientos realizados por el sistema.

Las nuevas herramientas desarrolladas por el equipo de IA de Facebook son accesibles en AI Habitat, la plataforma de simulación de la compañía que está diseñada para entrenar sistemas de IA incorporados en entornos 3D realistas.

Habitat se lanzó el año pasado como un proyecto de código abierto, como parte de un esfuerzo por proporcionar una plataforma estándar para ejecutar experimentos con IA incorporada y comparar resultados.

Grauman dijo que la visión a largo plazo del proyecto es que los sistemas de IA incorporados utilicen varios «sentidos» diferentes, como la visión y el oído, por ejemplo, para llevar a cabo tareas en entornos del mundo real.

«Con este proyecto, estamos tratando de ir más allá de las capacidades actuales y entrar en escenarios como preguntarle a un robot doméstico ‘¿Puedes ir a verificar si mi computadora portátil está en mi escritorio? Si es así, tráemelo’. O el robot escucha un ruido sordo proveniente de algún lugar de arriba y va a investigar dónde está y qué es», dijo Grauman.

Para familiarizar a los asistentes virtuales con el mundo real, la plataforma Habitat incluye el conjunto de datos de entornos 3D fotorrealistas de Facebook Reality Labs, Replica, que contiene reconstrucciones detalladas de distintos espacios. Habitat también es compatible con conjuntos de datos existentes como Gibson y Matterport3D.

El siguiente paso será transferir las habilidades desarrolladas en la plataforma virtual a robots reales. Los primeros experimentos en la transferencia de habilidades de Habitat a un robot físico han sido descritos como «prometedores» por los investigadores de Facebook.

Sin embargo, Grauman dijo que es difícil decir de forma exacta cuándo podremos esperar asistentes virtuales encarnados en los hogares. Si bien los laboratorios de investigación están trabajando duro para establecer las condiciones adecuadas para la tecnología, siguen existiendo desafíos importantes.